翻译自:Meta Blog

原文:How Meta Movie Gen could usher in a new AI-enabled era for content creators

无论是渴望在好莱坞成名的电影制作人,还是热衷于为观众创作视频的创作者,我们相信每个人都应拥有助力创意的工具。今天,我们兴奋地推出 Meta Movie Gen,这是我们针对媒体,具有突破性的生成式 AI 的研究,其中包括图像、视频和音频等模式。我们的最新研究表明,用户可以通过简单的文本输入生成定制视频和声音、编辑现有视频,甚至将个人图像转化为独特的视频。经过人类评估,Movie Gen 在这些任务上超越了行业内的其他类似模型。

这项工作是我们在社区分享基础 AI 研究这项长期承诺的一部分。我们的第一波生成式 AI 工作始于 Make-A-Scene 系列模型,它使得图像、音频、视频和 3D 动画的创作成为可能。随着扩散模型的出现,我们进入了第二波发展,推出了 Llama Image 基础模型,提升了图像和视频的生成质量以及图像编辑能力。Movie Gen 是我们的第三波,结合了所有这些媒介,并为用户提供前所未有的精细化控制。我们预期这些模型将催生多种新产品,从而加速创意的实现。

虽然这些基础模型有许多令人兴奋的应用场景,但需要指出的是,生成式人工智能并不是艺术家和动画师工作的替代品。我们分享这项研究是因为我们相信,这项技术能够帮助人们以全新方式表达自己,并为那些可能没有机会的人提供更多可能性。我们希望,未来的某一天,每个人都能利用 Movie Gen 实现自己的艺术愿景,创作出高清晰度的视频和音频。

背后的故事

作为最先进、沉浸式的叙事模型套件,Movie Gen 拥有:视频生成、个性化视频生成、精准视频编辑和音频生成,四大功能。我们在获得授权和公开可用的数据集上训练了这些模型。尽管我们在研究论文中提供了更多技术细节,但在这篇博客中,我们将分享每项功能的表现。

视频生成

通过文本提示,我们利用一个经过优化的联合模型,该模型同时支持文生图像和文生视频,能够创建高质量和高清晰度的图像和视频。这个拥有 30 亿参数的 Transformer 模型能够生成最长 16 秒、每秒 16 帧的视频。我们发现,模型能够推理出对象运动、主体与对象的互动以及相机运动等状态,并能学习多种合理运动的概念,使其在同类 AI 模型中处于领先地位。

个性化视频

我们还扩展了上述基础模型,以支持个性化视频生成。我们以个人图像和文本提示作为输入,生成包含参考人物丰富细节的视频。我们模型创造的视频,能够保留人物的形象特征和运动表现,并且达到了行业领先水平。

精准视频编辑

作为一个具备编辑功能的基础模型,Movie Gen 能够根据文本提示对视频进行精准编辑,生成理想的结果。它结合了视频生成和高级图像编辑功能,支持局部修改(如添加、删除或替换某些元素)和全局调整(例如更改背景或风格)。与传统视频编辑工具或缺乏精准度的视频生成模型相比,Movie Gen 不需要专业技能,能够在保留原始内容的基础上,仅对需要修改的部分进行编辑,从而精准地制作出想要的视频。

音频生成

最后,我们训练了一个拥有 130 亿参数的音频生成模型,可以根据视频和文本提示生成高质量、高保真的音频,时长可达 45 秒,涵盖环境声音、音效(如拟声)和背景音乐,所有内容均与视频完美同步。此外,我们还引入了一种音频扩展技术,能够为任意长度的视频生成连贯的音频,在音质、视频与音频的同步以及文本与音频的匹配方面均达到了行业领先水平。

结果

这些基础模型促使我们在架构、训练目标、数据配置、评估标准和推理优化等多个技术领域进行创新。

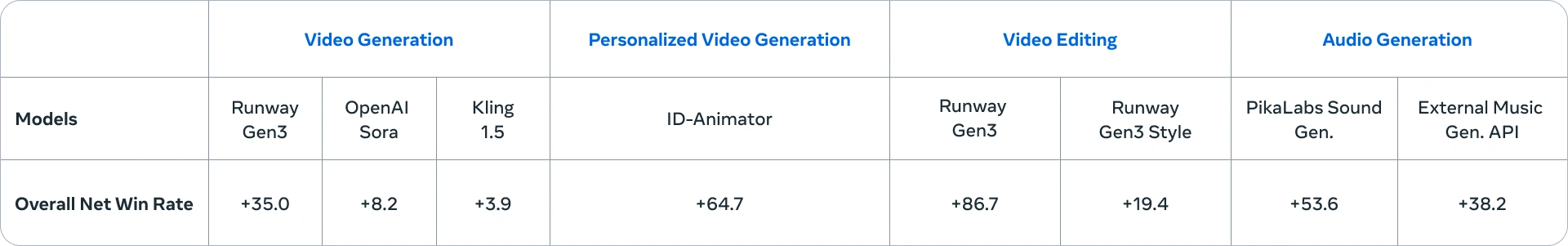

以下是我们在四项功能上的人工评估对比结果。正向胜率表明,用户更倾向于选择我们的模型结果而非竞争对手的。有关更多细节和评估,欢迎查阅我们的论文。

尽管我们今天分享的研究展示了未来应用的巨大潜力,但我们也承认当前模型仍存在一些局限性。特别是,我们还有许多优化空间,以进一步缩短推理时间并提升模型质量。

未来之路

随着我们对模型的不断改进,我们将与电影制作人以及创作者紧密合作,整合他们的反馈。通过这种合作方式,我们希望确保开发出能够帮助人们以全新方式提升创意的工具,超越他们曾经的梦想。想象一下,制作一段“生活中的一天”视频并通过文本提示进行编辑,或者为朋友定制一段动画生日祝福并通过 WhatsApp 发送。随着创造力和自我表达的不断增强,未来的可能性将是无限的。

评论(0)