Google 发布了全新的开源大语言模型 Gemma 3,是一款从 Gemini 大模型中蒸馏而来的轻量级模型。Gemma 提供了 1B、4B、12B 和 27B 四种参数规格,支持多模态输入、12万 Tokens 上下文长度,以及 140 种语言的处理能力。

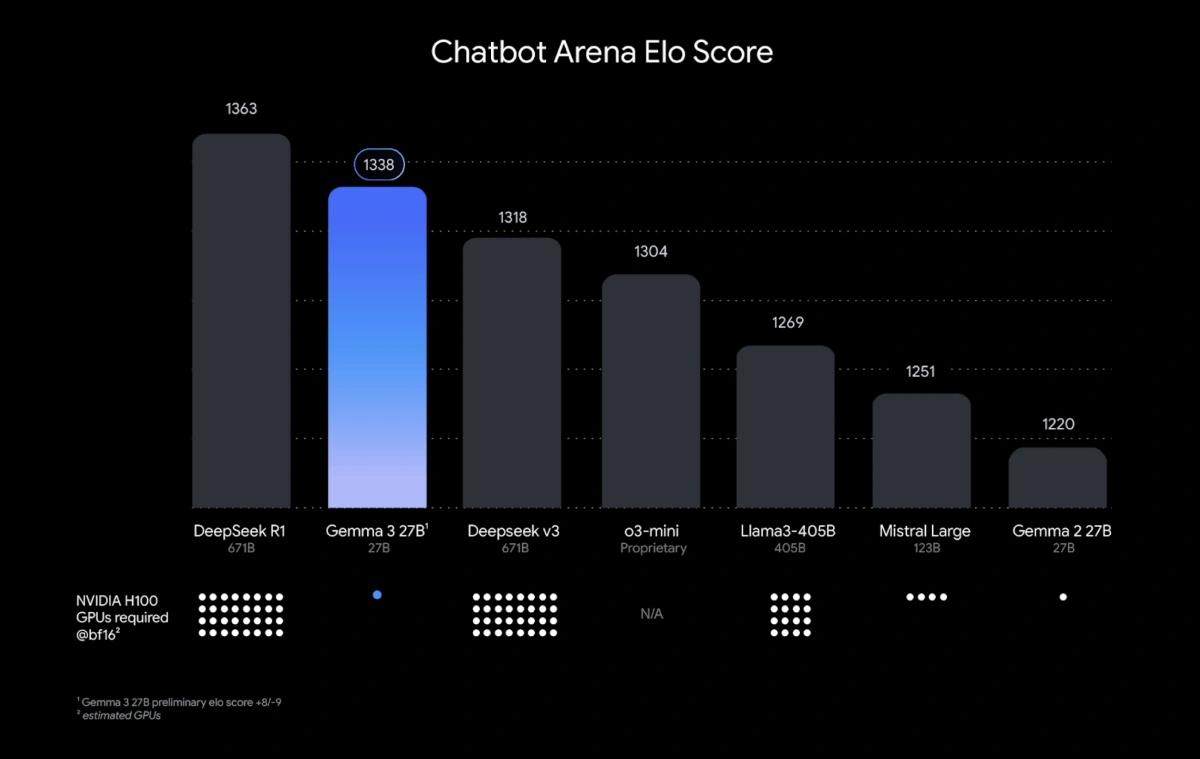

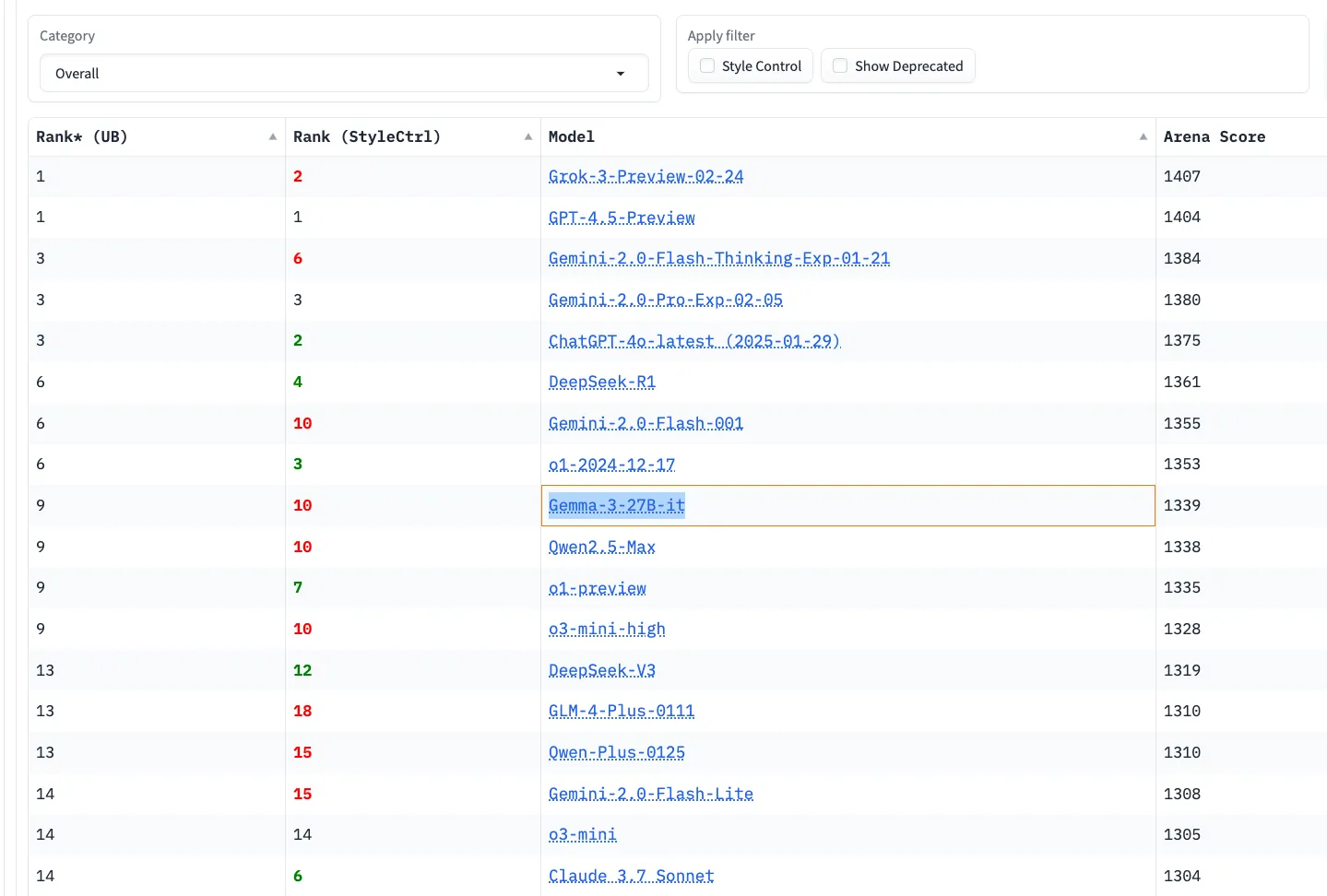

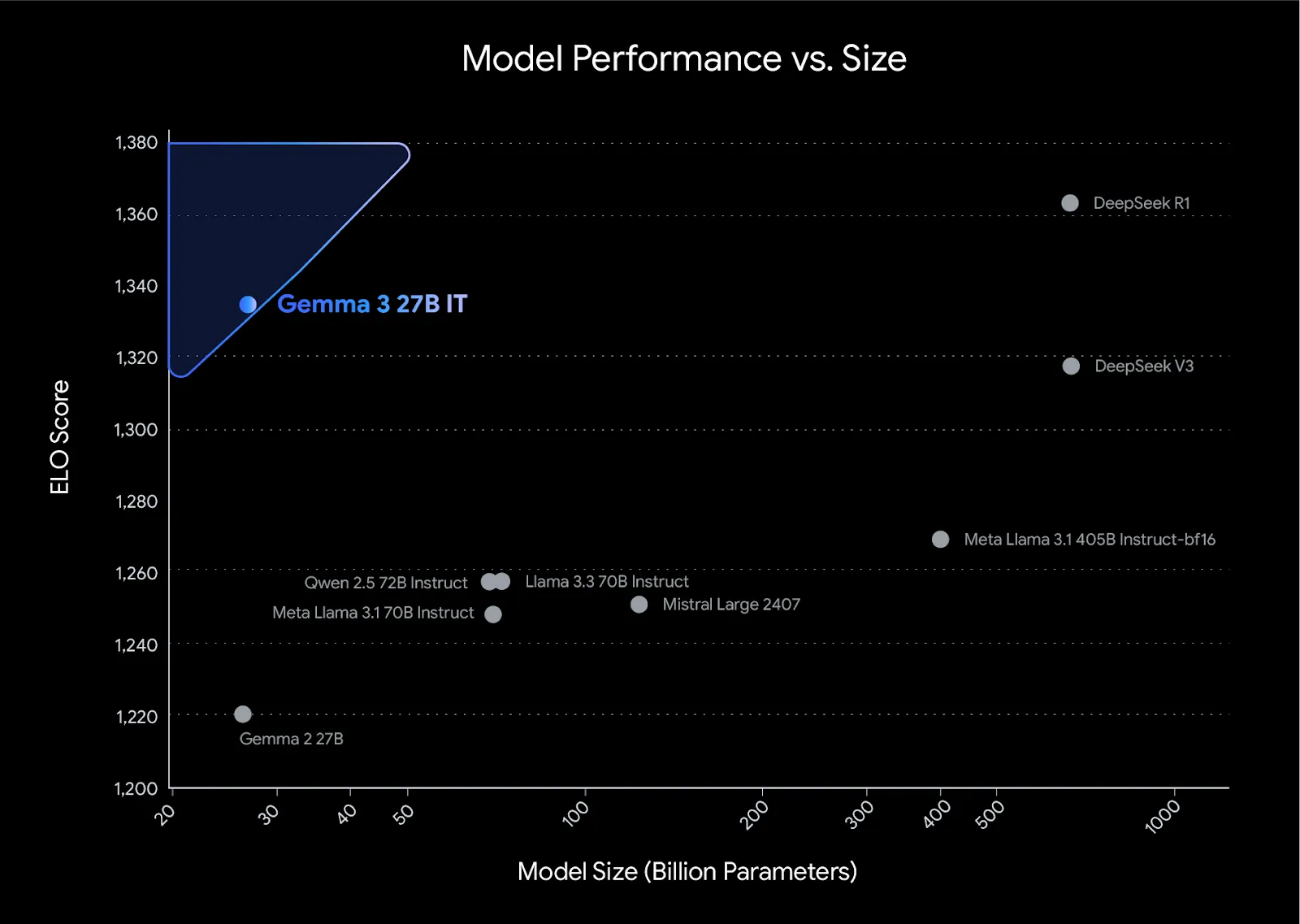

Gemma 3 在性能与规模的平衡上表现十分优异。其中 27B 参数版本在 Chatbot Arena 的 Elo 评分达到 1339 分,排名第九,与一些规模更大的模型并驾齐驱。这充分展示了模型蒸馏技术在压缩模型尺寸同时保持性能方面的潜力。

Gemma 3 的另一大亮点是本地部署的便利性。除了最大的 27B 版本可能需要较高配置外,其他版本都能在普通笔记本电脑上流畅运行。以 MacBook Pro M2 32GB 为例,4B 和 12B 版本都可以轻松驾驭,这为个人用户和开发者提供了私密且低成本的 AI 解决方案。实际测试表明,Gemma 3 在结构化输出、JSON 生成等任务上表现出色。

来自 LangChain 的开发者 Landon Langham 将 Gemma 3 整合进他的开源项目 ollama-deep-researcher 中,实现了基于本地模型的智能研究助手。该助手能够进行迭代式搜索和总结,运行速度快,且成本几乎为零。

本地安装 Ollama Gemma 3

ollama pull gemma3:4b

本地安装 LangChain ChatOllama

%pip install -qU langchain-ollama

在 Python 中调用 ChatOllama

from langchain_ollama import ChatOllama

llm = ChatOllama(

model="gemma3:4b",

temperature=0,

# other params...

)

Ollama Deep Researcher 项目地址:https://github.com/langchain-ai/ollama-deep-researcher

值得一提的是,Google 在 Gemma 3 的训练中采用了 RLF、RLMF 和 RLEF 等先进技术,特别优化了数学和编程能力。这使得 Gemma 3 不仅是一个通用的语言模型,更是一个具备专业能力的 AI 助手。

如今,大语言模型可谓百花齐放,Gemma 3 的发布展现出了一个新的趋势。通过模型蒸馏等技术,在保持核心性能的同时能够大幅降低部署门槛。这种趋势或将推动 AI 技术走向更广泛的实际应用场景,让更多用户受益于 AI 技术的进步。

评论(0)